🚀 惊喜不断,DeepSeek持续放大招

在热闹非凡的DeepSeek开源周,每天都有新惊喜。第四天,DeepSeek又带着超厉害的并行优化策略成果闪亮登场,直接戳中AI模型训练的痛点,让开发者们直呼过瘾!

💥 两大创新技术,为训练加速

DualPipe:计算通信的“超级协调员”

想象一下,在AI模型V3/R1的训练过程中,计算和通信就像两个忙碌的工人,如果各自为政,工作效率就会大打折扣。DualPipe这个双向流水线并行算法,就像是一位超级协调员,让计算和通信这两个环节能同时进行,实现“计算 – 通信重叠”。

有了DualPipe,大规模语言模型或者视觉模型训练时,不再需要漫长的等待,训练周期大幅缩短。就好比原本一趟需要跑很久的接力赛,现在通过更好的交接安排,速度一下子就提上来了。开发者们可以赶紧去这个GitHub链接,把这位“协调员”领回家!

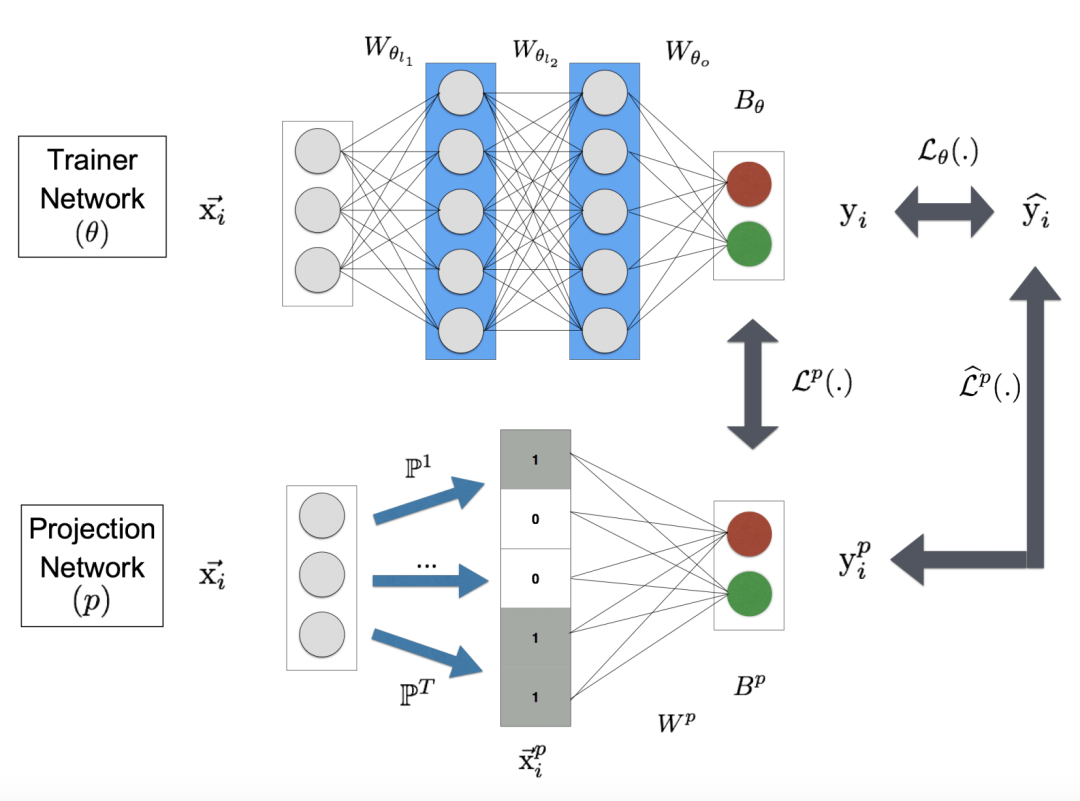

EPLB:专家并行的“智能调度官”

在V3/R1模型中,有一种混合专家(MoE)模型,里面不同的专家模块就像不同技能的工人。但有时候,有的“工人”忙得不可开交,有的却闲得没事干,这可不行。

EPLB,也就是专家并行负载均衡器,就像一位智能调度官,它能精准地给每个专家模块分配合适的任务,让大家的工作量都差不多,充分发挥硬件的计算能力。这样一来,模型训练过程就更加顺畅高效啦。想让你的模型训练也有这么一位“调度官”?点击这个链接 就能找到它。

📈 深度分析,助力优化

DeepSeek不仅带来了实用的工具,还分享了关于V3/R1中计算通信重叠的分析内容。这就像是给开发者们一本“武功秘籍”,通过深入了解模型训练中的性能瓶颈,大家就能更好地优化自己的模型训练过程。这份分析内容也已经开源,就在这个GitHub链接 ,千万别错过!

DeepSeek开源周第四天的这些宝贝,为AI模型训练的并行优化提供了超棒的思路和工具。相信在它们的助力下,开发者们能更轻松地打造出强大的AI模型。而DeepSeek后续还会带来什么惊喜,让我们一起拭目以待!

暂无评论内容